La Mecánica Cuántica y la teoría de la relatividad son las dos grandes teorías de la Física del siglo XX. Ambas surgieron a principios del siglo pasado para explicar fenómenos que contradecían las predicciones de la Física Clásica, nacida con Isaac Newton en el siglo XVII El nombre Mecánica Cuántica fue utilizado por primera vez por Max Born en 1924 en un paper que llevaba como título:

Sobre Mecánica Cuántica (Zur Quantummechanik).

La Mecánica Cuántica brinda el marco general para describir sistemas físicos en todas las escalas, desde las partículas elementales (tales como electrones y quarks), núcleos, átomos y moléculas hasta la estructura estelar. Su campo de aplicación es universal, pero es en sistemas de dimensiones muy pequeñas donde sus predicciones difieren sustancialmente de aquellas proporcionadas por la física clásica. Recordemos aquí que la dimensión de un átomo es muy pequeña: Típicamente una diez millonésima de milímetro! (0,0000001 mm, equivalente a un Angstrom). Y la de un núcleo atómico es aún cien mil veces menor (0,000000000001 mm, equivalente a un Fermi).

Según expresa Richard Feynman

en su texto de Mecánica Cuántica, la relación entre la física clásica y la cuántica es la misma que hay entre un objeto y su sombra. La sombra nos permite conocer de manera aproximada la forma del objeto, pero no es posible reconstruir de forma directa el objeto original a partir de su sombra. Análogamente, en la mecánica clásica existen sombras de las leyes de la mecánica cuántica que son las que verdaderamente se encuentran en la base de todo. La mecánica clásica es solo una aproximación.

La mecánica cuántica resulta así imprescindible para explicar satisfactoriamente todas las propiedades de la materia. Es la base de los desarrollos tecnológicos de mayor éxito de la segunda mitad del siglo XX, constituyendo el fundamento de la química moderna y de la microelectrónica actual (incluyendo las computadoras).

La mecánica cuántica (también llamada física cuántica) nos revela aspectos muy sorprendentes de la naturaleza, aún más lejanos a nuestra intuición que los predichos por la teoría de la relatividad. Esto es natural pues nuestra intuición se desarrolló en el mundo macroscópico cotidiano (donde las distancias son mucho mayores que las atómicas y las velocidades mucho menores que la velocidad de la luz), el cual es correctamente descripto por la física clásica. En sistemas macroscópicos las predicciones cuánticas coinciden normalmente con las de la física clásica.

Porque en esta teoría, las magnitudes físicas tales como la energía y otras cantidades importantes están normalmente cuantizadas: No pueden tomar cualquier valor, sino sólo ciertos valores posibles, que pueden ser determinados en experimentos o mediante complejas (¡pero elegantes!) ecuaciones matemáticas.¿Porqué se llama Mecánica Cuántica?

Veamos un ejemplo: Mientras que una rueda de bicicleta puede en principio girar alrededor de su eje con cualquier velocidad de rotación, y por lo tanto tener cualquier energía (energía cinética de rotación), una molécula rotante (rotador cuántico) puede tener sólo determinadas energías de rotación. Así, mientras la energía de la rueda de bicicleta puede variarse en forma continua incrementando su velocidad, la energía de rotación de una molécula sólo puede incrementarse de a saltos.

Y más sorprendente aún resultan los valores que puede tomar la energía. Por ejemplo, para una molécula diatómica como la del cloruro de hidrógeno (HCl, que en solución acuosa se denomina ácido clorhídrico o comunmente ácido muriático) los valores son

0, 2, 6, 12, 20, etc.,

en unidades de energía apropiadas. Es decir, no son valores al azar sino ciertos múltiplos enteros de una determinada unidad de energía. Parece mágico, ¿no? Estos valores son los predichos por la teoría cuántica y coinciden, por supuesto, con los medidos experimentalmente. La cuantización de la energía explica en particular las señales de luz emitida por átomos (espectro de emisión).

Para los interesados en conocer más detalles, las energías del rotador cuántico son de la forma E L(L+1) ...

Si esto te pareció sorprendente, es sólo el comienzo de las grandes sorpresas que nos depara la mecánica cuántica (Einstein se refería a veces a la misma como "cálculo de magia negra".)

Algunas fechas importantes

Las ideas que posibilitaron el desarrollo de la Teoría nacieron hacia fines del siglo XIX con Planck.

Los aportes más notables fueron:

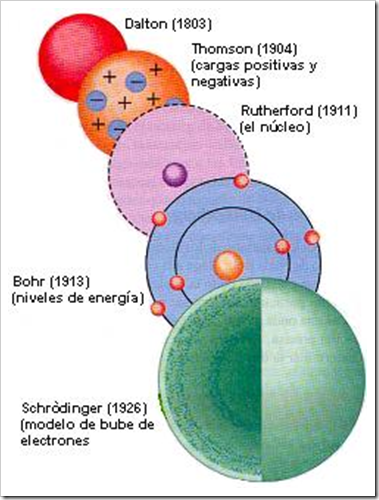

1900: Postulado de Planck de la radiación del cuerpo negro.

1905: Einstein da la explicación del efecto fotoeléctrico.

1913: Bohr introduce el llamado Modelo de Bohr del átomo de hidrógeno.

1924: de Broglie postula que la materia se comporta también como una onda

1925: Pauli Postula el llamado Principio de Exclusión

1926: Schrödinger introduce la Ecuación de onda

De Broglie |

Pauli |

Schrodinger |

1926: Born introduce el concepto de densidad de probabidad asociado a la función de onda

1927: Heisenberg introduce el Principio de Incertidumbre

1928: Dirac introduce la ecuación de onda relativista de la Mecánica Cuántica

La formulación general de la Teoría Cuántica la realizan Heisenberg-Schrodinger y Dirac entre 1925 y 1926 dando un Marco general para describir sistemas físicos, desde partículas elementales, núcleos y átomos.... y hasta estructura estelar. La teoría implica limitaciones a la precisión con que se puede caracterizar el estado de un sistema, pero realiza predicciones muy precisas sobre los valores medibles de cantidades físicas (energía, spin, etc.) asignando valores discretos (en lugar de continuos)

Principio de Incertidumbre

Heisenberg

Un aspecto fundamental de la Mecánica Cuántica es el Principio de Incertidumbre, debido a Werner Heisenberg. Dicho principio dice que a mayor precisión sobre la medida de la posición de una partícula, menor precisión habrá sobre su velocidad y viceversa. Esto implica que en mecánica cuántica no podemos hablar ni siquiera de trayectoria (si sabemos donde está, no sabemos para donde se mueve y viceversa). Por supuesto que en estas consideraciones interviene nuevamente la constante de Planck h, y por ello estos efectos se vuelven insignificantes en el mundo macroscópico cotidiano. Más detalles interesantes sobre el principio de incertidumbre pueden encontrarse

aquí.

Efecto túnel

En nuestro universo cotidiano gobernado por las leyes de la Física Clásica, sabemos que es imposible que al arrojar una pelota contra una pared, la pelota pase a través de ella. Sin embargo, en la mecánica cuántica un objeto sí puede atravesar una pared (que en el mundo microscópico corresponde a una barrera de potencial), con una cierta probabilidad. Este fenómeno, que es uno de los más interesantes y curiosos del mundo cuántico, se conoce como efecto túnel y es la base del funcionamiento de los circuitos integrados que se usan para construir computadoras. Es también la base de la fisión nuclear. Otra aplicación importantísima es el microscopio de efecto túnel

¿Ondas o partículas? ¡Ambas!

En la física clásica, las ondas son ondas y las partículas son partículas. Sin embargo, esto no es así en la mecánica cuántica!, donde las ondas electromagnéticas (que de acuerdo a su frecuencia se manifiestan como luz, rayos infrarrojos, ondas de radio, TV, rayos ultravioleta, rayos X, rayos Gamma, etc.) pueden exhibir propiedades de partícula (fotones), mientras que las partículas pueden también exhibir propiedades de onda!

Puede decirse que tanto la luz y la materia existen en la mecánica cuántica como partículas, y lo que se comporta como onda es la probabilidad de encontrar dichas partículas en algún lugar. Véase también .

El principio de superposición

En nuestro mundo cotidiano (que de aquí en más llamaremos el mundo clásico), uno puede estar vivo o muerto, es decir, en un estado vivo, o en un estado muerto, pero claramente no puede estar en una superposición de ambos estados, es decir, vivo y muerto al mismo tiempo.

Sin embargo, un sistema cuántico sí puede estar en una superposición de estados. El principio de superposición, uno de los principios fundamentales de la Mecánica Cuántica, establece que si un sistema cuántico puede estar en un estado A (por ejemplo vivo) o en un estado B (muerto), puede también estar en una superposición de ambos!

¿Qué significa esto?: Supongamos un sistema cuántico que puede tener energías A y B. Si el sistema está en el estado de energía A, cuando medimos su energía se obtiene el valor A. Y si está en el estado de energía B, al medir obtenemos la energía B. Pero cuando está en una superposición de ambos estados, cuando medimos se puede obtener tanto la energía A como la B, con ciertas probabilidades, las cuales quedan determinadas por el tipo de superposición. Es importante destacar que no se obtiene un valor intermedio entre A y B.

No es sólo un problema de probabilidades! En este punto, algunos lectores pensaran que la situación es confusa pero controlable. Es decir, podrían pensar "Lo que sucede es que cuando el sistema cuántico está en una superposición de estados, tiene una cierta probabilidad de estar en el estado con energía A, y otra de estar en el estado con energía B. Cuando se mide, se sabe entonces en cuál de los dos estados estaba."

Pero ahora la mecánica cuántica nos sorprende nuevamente: No es posible suponer que el sistema YA ESTABA en el estado A o en el estado B, sino que, para decirlo en forma breve, esto se decide en el momento de la medición, como consecuencia de la interacción entre nuestro aparato de medida y el sistema cuántico que es medido. Es decir, no es posible interpretar la superposición cuántica desde un punto de vista probabilístico tradicional. No existe un modelo clásico local puramente probabilístico que pueda predecir los resultados cuánticos. Este aspecto se ha investigado profundamente en los últimos años y las predicciones de la mecánica cuántica han salido siempre victoriosas en los experimentos! (Proximamente se darán en este sitio detalles sobre las desigualdades de Bell y la muy famosa paradoja EPR).

Entre otras cosas, el principio de superposición permite el fenómeno del entrelazamiento cuántico, el cual a su vez posibilita la

teleportación cuántica. Y como si fuera poco, la superposición de estados hace factible una forma completamente nueva de computación, denominada

computación cuántica, todavía en fase experimental y actualmente objeto de intensa investigación, la cual está basada en qubits (quantum bits) en lugar de bits, y permitiría reducciones extraordinarias en el tiempo de cómputo de ciertos cálculos.

¡Y hay más sorpresas!

Algunos desarrollos conceptuales notables de las últimas decadas:

1981: W. Zurek indtroduce los conceptos de decoherencia y estados puntero, proporcionando una teoría consistente de la medida en la mecánica cuántica

1982: W. Wooters y W. Zurek demuestran la imposibilidad de clonación exacta en la mecánica cuántica y sus profundas implicancias

1984: C.H. Bennett y G. Brassard introducen el concepto de criptografía cuántica (distribución cuántica de claves)

1985: David Deutsch introduce el concepto de computadora cuántica

1989: R.F. Werner introduce el concepto de entrelazamiento cuántico para estados cuánticos generales

1991: A. Ekert introduce la criptografía cuántica basada en entrelazamiento

1993: C.H. Bennett, G. Brassard, W. Wootters y otros introducen la teleportación cuántica, basada en el enrtelazamiento cuántico

1994: P. Shor demuestra que una computadora cuántica puede resolver el problema de la factorización en forma mucho más eficiente que uno computadora clásica, transformando el problema de duro a factible

1996: L. Grover demuestra que una computadora cuántica puede resolver el problema de búsqueda de manera más eficiente que una computadora clásica

2001: W. Zurek introduce el concepto de discordancia cuántica, que distingue correlaciones cuánticas no equivalentes al entrelazamiento

2008: C. Caves y otros demuestran que la discordancia cuántica juega un rol central en la computación cuántica basada en estados no puros

.png)